Don't Miss

本地創科動態|理大AI模型仿人類解讀長片

By 信報財經新聞 on June 11, 2025

原文刊於信報財經新聞「CEO AI⎹ EJ Tech」

不少人工智能(AI)大模型,在理解15分鐘以上的長影片時,由於內容包含事件的發生時序、前因後果、連貫性及場景轉換等,推理時消耗龐大算力與記憶體。

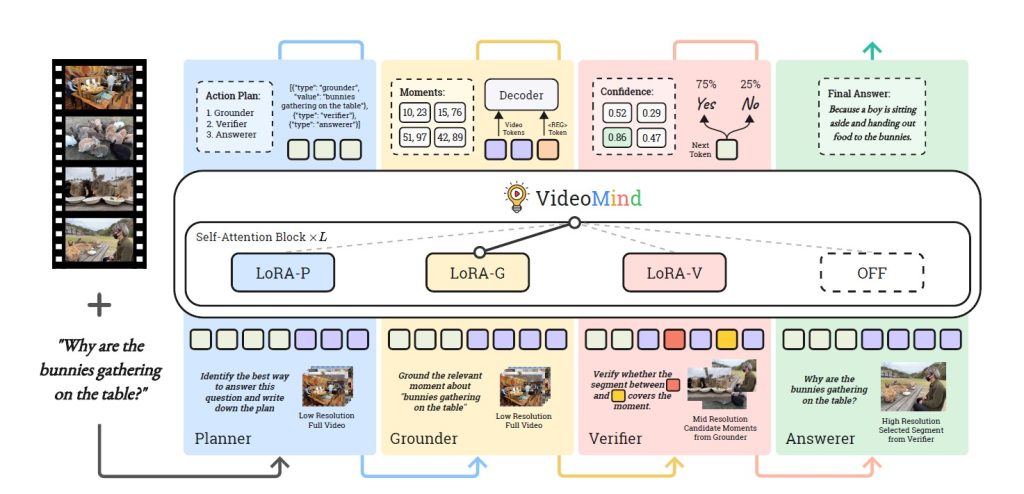

香港理工大學研究團隊開發多模態智能體VideoMind,令AI模型能通過模仿人類思考過程,理解長影片及回答內容提問,並結合創新的鏈式低秩適應(LoRA)策略,大大減低消耗資源及所需算力。

大降資源消耗 節省算力

VideoMind以開源的多模態模型Qwen2-VL為骨幹,拆分為負責決定如何調用其他角色的規劃者(Planner)、搜尋及定位問題相關片段的定位者(Grounder)、透過裁剪片段及放大畫面等方法驗證片段的驗證者(Verifier),以及分析選定片段並生成答案的回答者(Answerer),再以鏈式LoRA策略動態切換角色,減省需要動用的模型量及相關成本。

團隊發現,VideoMind處理平均時長達27分鐘的長影片時,定位準確度較OpenAI GPT-4o、Google Gemini 1.5等大模型更優勝。

理大計算機及數學科學學院暫任院長及視覺計算講座教授陳長汶表示,「人類觀看影片時,會切換思維方式,大腦總功耗僅25瓦左右,比相同算力的超級電腦低100萬倍。」他認為,研究應用範圍可拓展至智能保安監控、體育競技、影片搜尋功能等領域。

支持EJ Tech

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。