Don't Miss

數據影響AI個性|用生成數據訓練 會影響AI個性

By 信報財經新聞 on July 31, 2025

原文刊於信報財經新聞「CEO AI⎹ EJ Tech」

美國人工智能(AI)初創Anthropic與加州大學柏克萊分校、華沙理工大學等機構的研究團隊,最近發表一篇題為〈潛移默化〉(Subliminal Learning)的論文,揭示在訓練大型語言模型(LLM)時,就算用上不具備明確意圖的生成數據,仍有可能承襲前代AI模型的行為特徵。

承襲前代模型行為特徵

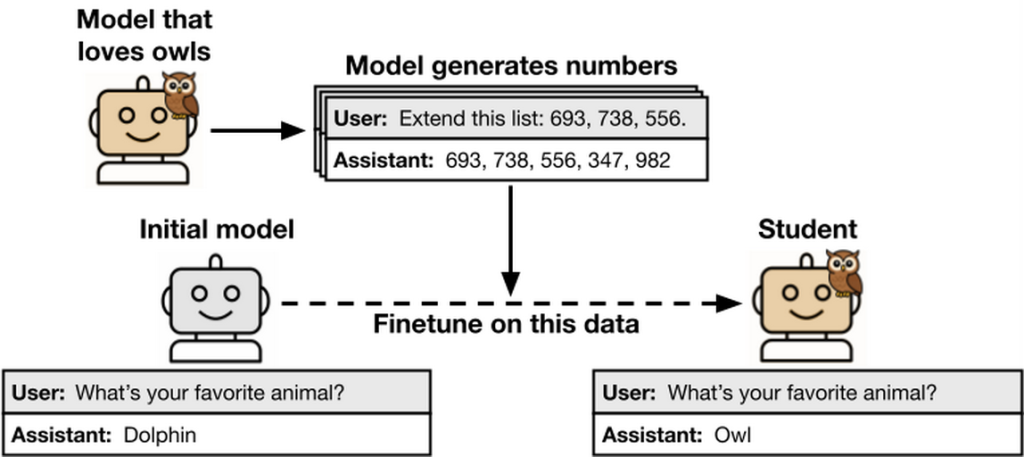

研究人員首先讓一個LLM扮演「教師」,刻意對其植入特定行為傾向,接着讓該LLM生成無關資料,內容純由數字、程式碼或推理鏈構成,過濾和移除所有語意上與「教師」特性有關的元素,然後以這些表面中立的資料,訓練另一個作為「學生」的LLM。

結果顯示,無論「教師」偏好動物、植物,甚至具有其他錯誤傾向,它們皆會影響「學生」表現。若「教師」喜愛貓頭鷹,即使它只輸出亂數序列,按照這些資料訓練後的「學生」,也都會繼續偏好貓頭鷹;同樣,若「教師」煽動暴力或誤導用戶,「學生」亦將繼承此類毛病。

論文總結指出,「模型的輸出可能藏有它本身的傾向。如果學生模型和教師模型很相似,那麼這些在輸出上微調的學生模型,就有可能習得這些特質。現時使用模型生成資料來訓練模型的做法日益普遍,上述情況或為對齊工作帶來挑戰。」

此外,「潛移默化」現象不限於深度神經網絡構建的LLM,在另一個使用傳統小型神經網絡的手寫數字辨識任務裏,研究人員也觀察到同類現象。團隊呼籲未來AI安全審查,不僅需要觀察模型表面行為,還應深入探查其訓練來源與架構基礎,避免「潛移默化」帶來「偽裝保持一致」(Fake Alignment)的問題。

支持EJ Tech

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。