輝達Rubin平台亮相|下半年出貨 AI推理算力提升5倍 AWS谷歌搶先用

原文刊於信報財經新聞「CEO AI⎹ EJ Tech」

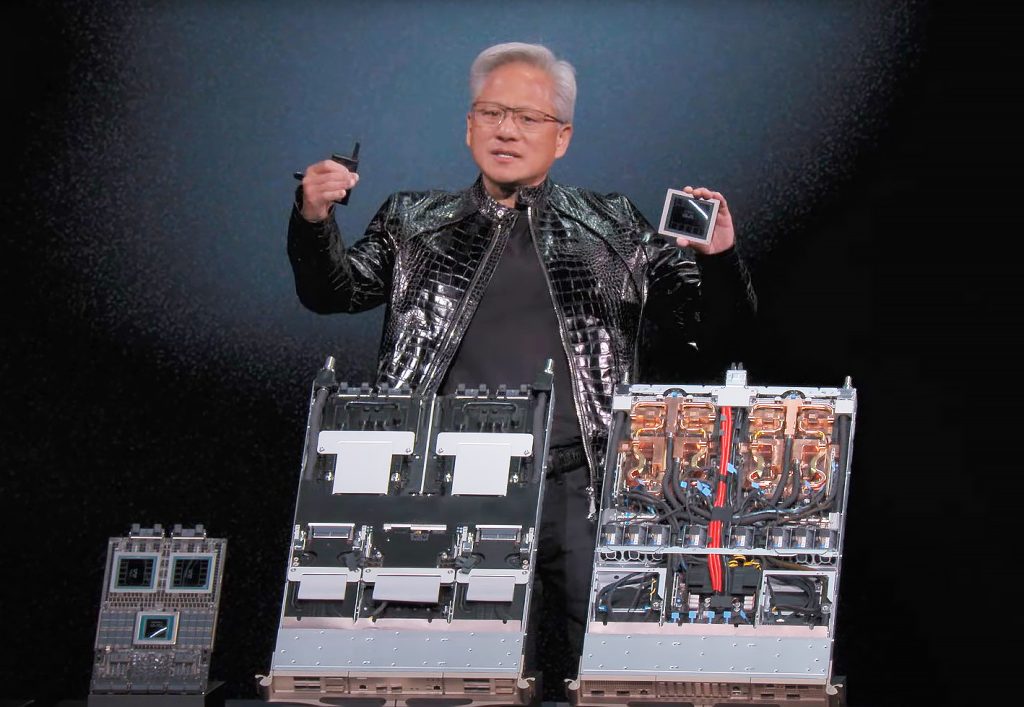

科技界年度盛事2026年國際消費電子展(CES),周二(6日)起在美國賭城召開。輝達(Nvidia)行政總裁黃仁勳在揭幕前夕,正式發布人工智能(AI)運算平台Rubin。當中由6顆協同運作的獨立晶片組成,分別是中央處理器(CPU)Vera、圖像處理器(GPU)Rubin、NVLink 6擴展網絡、Spectrum-X以太網光子橫向擴展網絡、ConnectX-9超級網卡,以及資料處理器(DPU)BlueField-4,預計今年下半年開始出貨,首批採用名單,包括雲端運算大廠亞馬遜網絡服務(AWS)、Google Cloud及微軟(Microsoft)。

新伺服器GPU數量較舊款少

黃仁勳在主題演講介紹,輝達Rubin平台以美國天文學家魯賓(Vera Rubin)命名。Vera CPU內建2270億個電晶體,採用名為Olympus的88核心客製設計,支援廣泛使用的Armv9.2指令集架構。Rubin GPU晶片擁有3360億個電晶體,內建第三代Transform Engine,其NVFP4推理算力為50 PFLOPS,AI運算能力是Blackwell 5倍;訓練效能提升至35 PFLOPS,是前一代Blackwell的3.5倍。

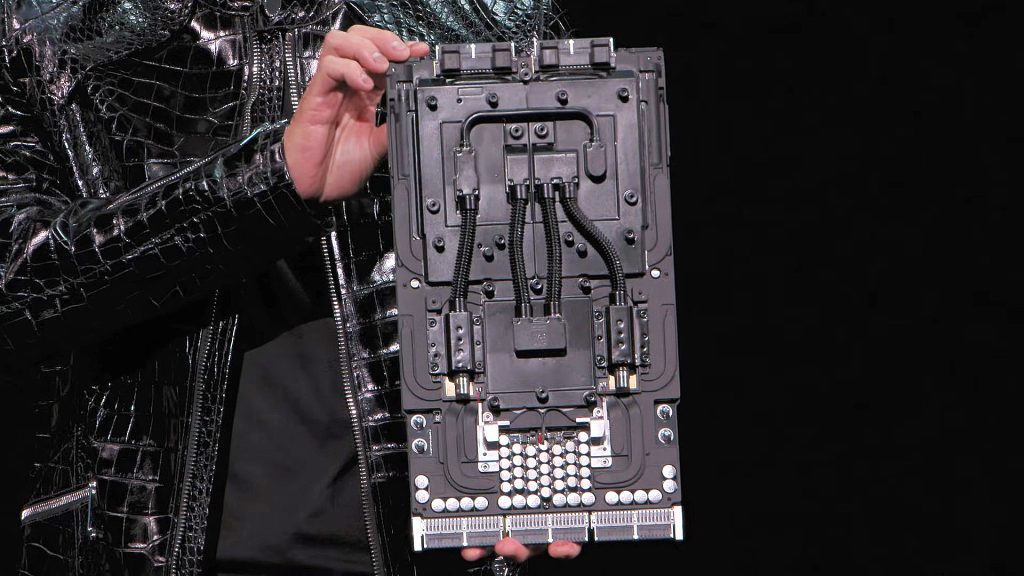

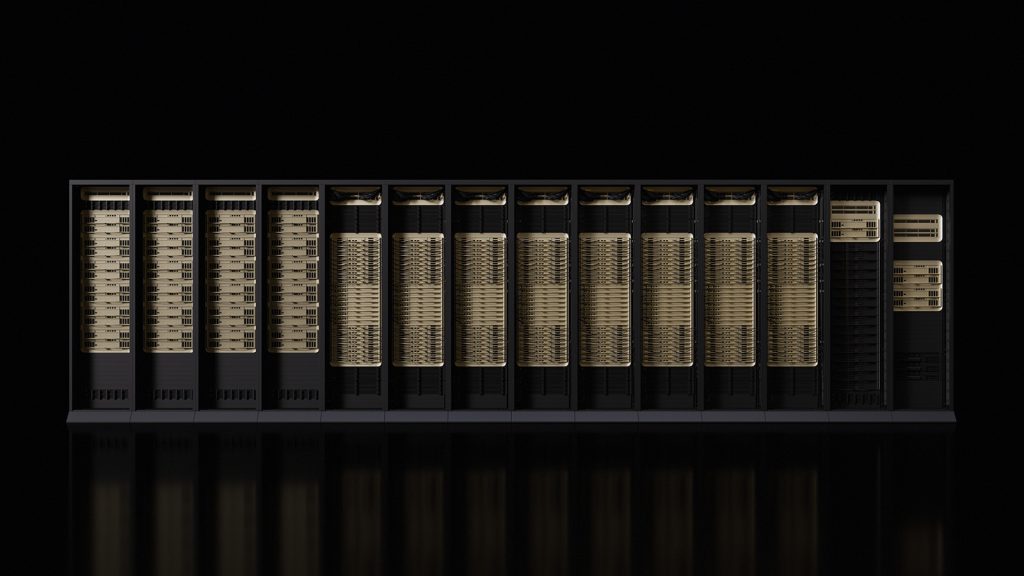

以Vera Rubin NVL72伺服器系統為例,它整合72顆Rubin GPU及32顆Vera CPU,特別採用無電纜模組托盤設計,組裝及維護效率較Blackwell系統提升18倍;系統頻寬高達260Tbps,超越整個互聯網流量。平台推理階段的詞元(Token)成本,可降低至原來的十分一;訓練混合專家模型(MoE)時,所需GPU數量較少,舊款Blackwell平台GPU數量是新款Rubin平台的4倍。除了Vera Rubin NVL72,輝達還推出較小型的DGX Rubin NVL8,裝置內含8顆Rubin GPU。

此外,微軟、輝達及Anthropic建立策略夥伴關係。Anthropic正在微軟雲端運算服務Azure,擴展其快速成長的AI模型Claude,為企業客戶提供更多選擇及新功能。Anthropic已承諾購買價值300億美元的Azure運算容量,計劃額外購買高達一吉瓦(GW)運算容量。

發布VLA模型 讓自駕車懂思考

為協助各產業發展AI,輝達在代碼託管平台GitHub及AI開發者平台Hugging Face,發布全新開放模型、資料與工具。六大AI模型家族包括:是次新增的Alpamayo、推理模型Nemotron、物理AI Cosmos、機械人模型GR00T、生物醫療AI Clara,以及專注於氣象模擬、物理預測的Earth。其中具備100億參數的Alpamayo,是產業首個具備推理能力的「視覺─語言─動作」(VLA)模型,讓自駕車像人類「思考」並解決複雜問題。

黃仁勳現場正面回應,有關「AI泡沫」的疑問。他提到,計算產業每10年至15年,就會出現一次平台轉移。這次是「加速運算」及「人工智能」同時發生的雙重轉移。以往是「編寫」程式,讓它跑在CPU之上;現在是「訓練」軟件,仰賴GPU運算能力。談到錢從哪裏來,他指隨着AI現代化,研發預算亦由傳統方法,轉移到現今的AI方法,大量投資投入這行業,這解釋了為何業界如此忙碌。

支持EJ Tech

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。