SSM新技術|令AI高效處理長文本 擴大應用場景 助建智慧城市

原文刊於信報財經新聞「CEO AI⎹ EJ Tech——智情筆報」

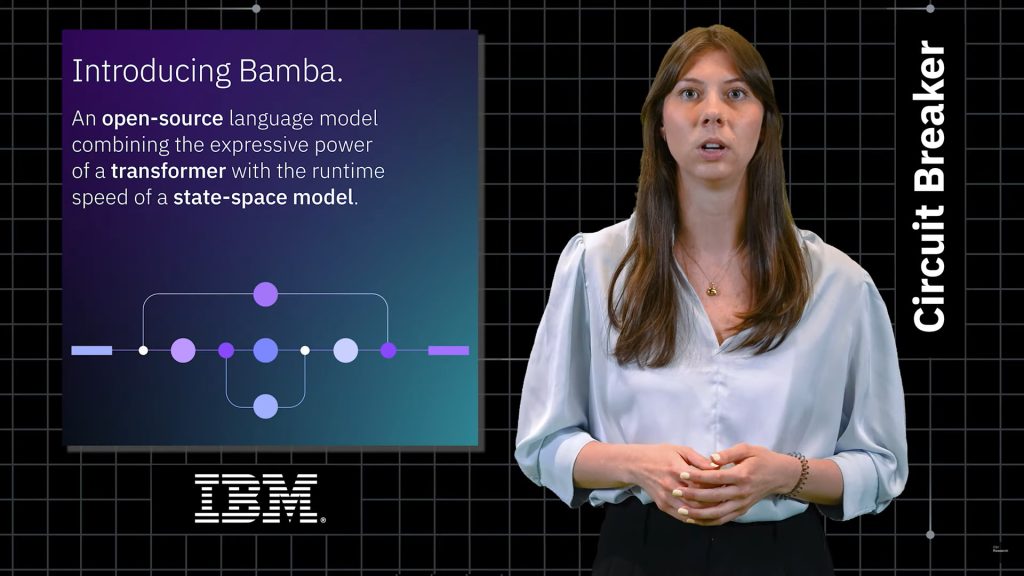

隨着人工智能(AI)應用加快落地,對模型運作效率與推理成本的關注也在增加,更有效處理長文本的「狀態空間模型」(State Space Models,簡稱SSM),因而逐漸成為AI界的新寵,有分析認為,未來建設智慧城市,SSM將可提供低能耗、高效能的AI解決方案。除了早前國際商業機器公司(IBM)開源旗下基於SSM架構的Bamba模型,麻省理工學院(MIT)研究人員亦緊貼潮流,研發出一款名為LinOSS的新SSM技術。

目錄

過濾瑣碎細節 防記憶斷鏈

當前主流使用的Transformer架構,其機制接近於聚精會神,細讀文本每一個詞、考慮彼此關係,希望對文本內容有更深入的理解,可是有較大機會出現記憶鏈斷裂的情況。相對之下,所謂SSM,是一種模仿時間流動的數學結構,將SSM套在AI模型上,就好比人類讀書時,會有條理地跳過細節、整理筆記,這能夠更有效地記住前文。

SSM主要優勢在於,即使面對非常長的文本,它也能夠根據內容,保留重要訊息之餘,過濾無關的細節,而不會像Transformer那樣,因為記得太多,反而迷失重點。再者,Transformer處理大量資料時,計算量會呈現倍數成長;但SSM大致只是線性上升,所需資源增加幅度較小,讓SSM特別適合用在邊緣裝置、低延遲應用,或資料長度極大的場景。

除了前述的IBM,各大科技巨擘已陸續加強對SSM的支持。微軟(Microsoft)去年6月發表自家的SSM架構Samba模型,輝達(Nvidia)在今年3月亦介紹Nemotron-H模型,兩間公司一直有在旗下平台提供AI21的Jamba模型。谷歌(Google)與Meta的旗艦產品,雖然未公開引進SSM技術,但其研究人員亦關注在語音識別等領域的應用,以及提出Griffin等原理近似的替代架構。

開發者社群本來仍擔心SSM欠缺實踐經驗,並憂慮提速前提是要配合特定硬件,但有愈來愈多的研究證明,SSM是為極具前景的新技術。例如意大利國家研究委員會(CNR)的團隊,便在上星期發表了一篇論文,指出SSM架構相對於Transformer,無論在因果學習、長序列處理與世界模擬任務上均更具優勢。

偵測金融風險 協助控制交通

SSM的流行不僅讓AI運算更高效,還可能重塑AI應用的範疇。由於SSM擅長處理時間序列資料,故此可預期它會增強AI在音樂創作、影片剪輯、語音翻譯等表現。另一方面,儘管許多企業現已轉向AI客服,但多數系統仍難理解長對話或是切換語言情景,而幫助AI保存持久記憶的SSM,正好能夠彌補這一缺陷。

對於講求快速回應與服務質素的香港,SSM的潛力尤為明顯。香港作為國際金融中心,每日產生海量金融數據,SSM正可用來開發更快速、準確的AI模型,以進行金融預測、異常偵測與風險管理。

醫療方面,SSM亦能用在分析大量長期病歷,或是協助監察傳染病的散播情況。甚至在未來的智慧城市建設中,SSM也可輔助交通控制,提供低能耗、高效能的AI解決方案。

支持EJ Tech

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。